Computación

Un algoritmo de inteligencia artificial permite a una supercomputadora procesar datos mucho más allá de su capacidad teórica

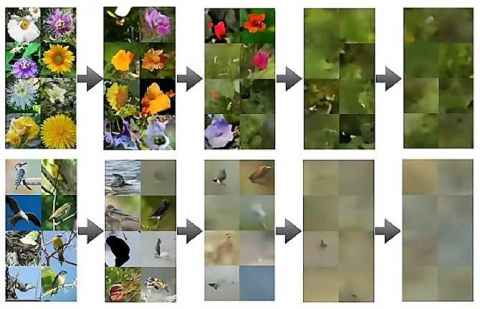

Un algoritmo de aprendizaje automático (una modalidad de inteligencia artificial) ha demostrado que puede dotar al ordenador donde se instale de la capacidad de procesar datos aunque superen ampliamente la memoria disponible del ordenador. El algoritmo identifica las características clave de un conjunto masivo de datos y divide el conjunto en lotes manejables que no ahogan el hardware del ordenador.

Desarrollado en el Laboratorio Nacional de Los Álamos, el algoritmo batió un récord mundial al procesar enormes conjuntos de datos durante una prueba realizada en Summit, la quinta supercomputadora más rápida del mundo, instalada en el Laboratorio Nacional de Oak Ridge, Estados Unidos.

Siendo igual de eficiente en una supercomputadora y en un ordenador portátil, el algoritmo resuelve los cuellos de botella de hardware que impiden procesar la información de aplicaciones con gran cantidad de datos, en campos como la investigación sobre el cáncer, el análisis de imágenes captadas desde satélite, el procesamiento de datos a gran escala de redes sociales, el estudio de terremotos y la seguridad nacional, por nombrar solo algunas.

El algoritmo lo ha desarrollado el equipo de Ismael Boureima, del Laboratorio Nacional de Los Álamos en Estados Unidos.

"El análisis de datos tradicional exige que los datos se ajusten a las limitaciones de memoria. Nuestro planteamiento desafía esta noción", afirma Manish Bhattarai, especialista en aprendizaje automático en el Laboratorio Nacional de Los Álamos y miembro del equipo de investigación y desarrollo. "Cuando el volumen de datos supera la memoria disponible, nuestro algoritmo divide el conjunto de datos en segmentos más pequeños. Procesa estos segmentos de uno en uno, introduciendo en la memoria y sacando de ella cada segmento según convenga. Esta técnica nos dota de una capacidad única para gestionar y analizar de forma eficiente conjuntos de datos extremadamente grandes".

![[Img #69849]](https://noticiasdelaciencia.com/upload/images/09_2023/8869_un-algoritmo-de-inteligencia-artificial-permite.jpg)

La supercomputadora Summit vista parcialmente desde una de sus esquinas. Ocupa un recinto tan grande como una nave industrial. (Foto: Oak Ridge National Laboratory)

En la ejecución récord del algoritmo, se procesó una matriz densa de 340 terabytes y una matriz dispersa de 11 exabytes utilizando solo 25.000 GPUs.

Boureima, Bhattarai y sus colegas exponen los detalles técnicos de su algoritmo y de lo que hace en la revista académica The Journal of Supercomputing, bajo el título “Distributed Out-of-Memory NMF on CPU/GPU Architectures”. (Fuente: NCYT de Amazings)